El aumento del uso de la inteligencia artificial (IA) está cambiando cómo trabajamos en el día a día. Si a ti aún no te ha cambiado la forma de trabajar, o te estás quedando fuera, o te cambiará en los próximos meses. Pero este cambio también afecta cómo tomamos decisiones en el trabajo: desde la selección de personal hasta la asignación de recursos. Y como las malas noticias nunca vienen solas, y a pesar del potencial beneficio transformador, la IA también está reproduciendo y amplificando los sesgos presentes en los datos y en los equipos que la desarrollan. Son sesgos culturales, de género, territoriales, económicos… Y es por eso que las mujeres, y los colectivos vulnerables, debemos ponernos las pilas para jugar un papel fundamental y cambiar las reglas del juego que se están estableciendo en este momento.

Lo decía en Ganyet hace unas semanas: Internet se ha convertido en 5 webs: Facebook, Instagram, Google, Amazon y Twitter. Todas controladas por 5 señores muy señores y muy poderosos. Estos sistemas establecen la información que nos llega a nuestro ordenador, teléfono y tableta. Es por eso que Elon Musk quiere eliminar la Wikipedia, porque no está en venta y tener un sistema jerárquico y social tan fuerte es difícilmente manipulable.

Los sistemas de IA son las herramientas del futuro donde recibiremos cómo pervivimos el mundo, y por eso ahora mismo hay una carrera de “quemar dinero” para hacerse con el trozo de pastel más grande del mercado. Estas herramientas basan su inteligencia en grandes cantidades de datos históricos (algunos propietarios, otros libres y abiertos) para entrenar modelos que tomen decisiones y nos las muestren. Estos datos no son “neutros”, son los que actualmente tienen los señores que controlan los medios y el contenido en Internet, y reflejan las desigualdades del presente y del pasado.

"Se ha demostrado que los algoritmos de selección de personal pueden penalizar los salarios de las mujeres porque los datos históricos muestran que ellas han tenido un 30% menos de salario por una misma posición"

Por ejemplo, se ha demostrado que los algoritmos de selección de personal pueden penalizar los salarios de las mujeres porque los datos históricos muestran que ellas han tenido un 30% menos de salario por una misma posición. Por lo tanto, esta desigualdad debe identificarse y corregirse manualmente.

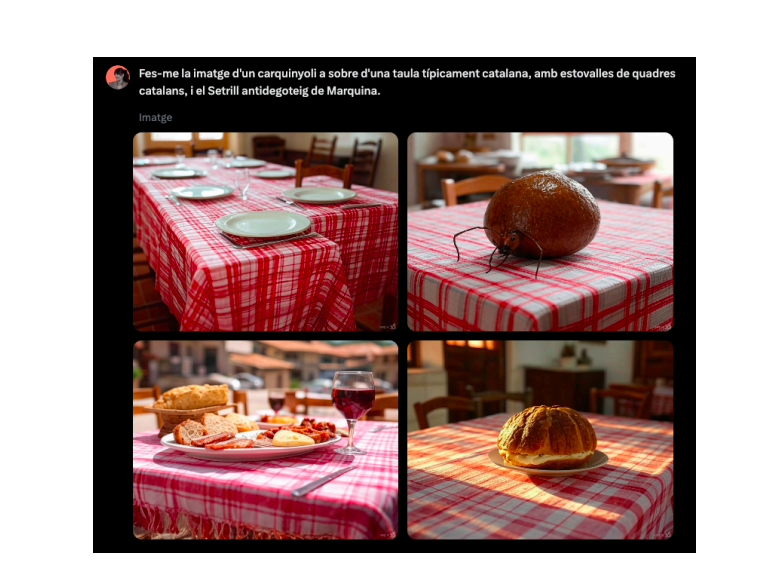

Otro ejemplo sería cuando pedimos a una IA generativa que nos haga una imagen de un carquinyoli. Como se han entrenado con datos americanos o chinos, y allí el tema carquinyoli lo llevan regular, suelen pintar una especie de coca o un donut. Para ellos es lo que más se asemeja a un carquinyoli. Pueden hacer la prueba.

Los sesgos no son meramente accidentes técnicos, sino el resultado de una falta de diversidad histórica en los equipos que mandan, diseñan e implementan estas tecnologías. Cuando el 78% de los profesionales de la IA son hombres, según los últimos datos, las perspectivas y experiencias femeninas quedan infrarepresentadas, pero también en diversidad de orígenes, vivencias o capacidades.

"Los sesgos no son meramente accidentes técnicos, sino el resultado de una falta de diversidad histórica en los equipos que mandan, diseñan e implementan estas tecnologías"

Pero, ¿qué pasa cuando mujeres lideran equipos tecnológicos? Se han observado avances significativos en la identificación y corrección de sesgos. Por ejemplo, la investigadora y activista digital ghanesa-americana Joy Buolamwini demostró cómo los sistemas de reconocimiento facial tenían una tasa de error mucho más elevada para mujeres negras que para hombres blancos. Su trabajo provocó que empresas como IBM y Microsoft revisaran sus algoritmos. ¿Nadie se había fijado antes? Quizás sí, pero no les interesaba corregirlo. O quizás no, y eso denota que nadie se había encontrado en ese entorno.

Las mujeres líderes en IA también están impulsando una tecnología que prioriza el impacto social positivo. Programas diseñados para detectar violencia doméstica, algoritmos que mejoran el acceso a la educación para niñas en países en desarrollo, o que tienen la mirada en sus hijos con capacidades diversas. Son a menudo el sello de mujeres en posiciones de liderazgo: que miran los cuidados y sus problemáticas diarias.

A pesar de estos avances, las mujeres aún enfrentan numerosos obstáculos para acceder a posiciones de poder en el campo de la tecnología. Estos incluyen la falta de mentores y mentoras, sesgos implícitos durante los procesos de selección, la difícil y maldita conciliación, y una cultura corporativa que a menudo desincentiva la diversidad. Además, las voces críticas femeninas son, a veces, silenciadas o ignoradas, como sucedió con la salida polémica de Timnit Gebru de Google, una de las expertas más destacadas en ética de la IA, que fue víctima de sus descubrimientos sobre los sesgos en la empresa.

"Las mujeres líderes en IA también están impulsando una tecnología que prioriza el impacto social positivo"

El futuro de la IA no está escrito, y tener perfiles diversos es imprescindible para identificar los sesgos. Necesitamos herramientas que no solo sean precisas, sino también justas y representativas. Esto requerirá esfuerzos coordinados: programas educativos que incentiven a tener una buena mirada digital crítica a todas las edades, políticas corporativas que promuevan la diversidad y, sobre todo, el reconocimiento del valor que aportan las mujeres y los perfiles diversos a un campo clave para nuestro futuro colectivo.

Quizás aún no sabemos qué formas tomarán las tecnologías que vendrán, pero podemos imaginar un horizonte donde los algoritmos sean tejidos con justicia y empatía, reflejando la diversidad de los sueños humanos. Al fin y al cabo, construir una IA inclusiva es más que un reto técnico: es una declaración de quién queremos ser como sociedad. Otro debate es si los genios del apocalipsis, que pregonan aquello de que “el mercado se regulariza solo”, quieran que tengamos una sociedad más empática y justa. Vienen tiempos oscuros.